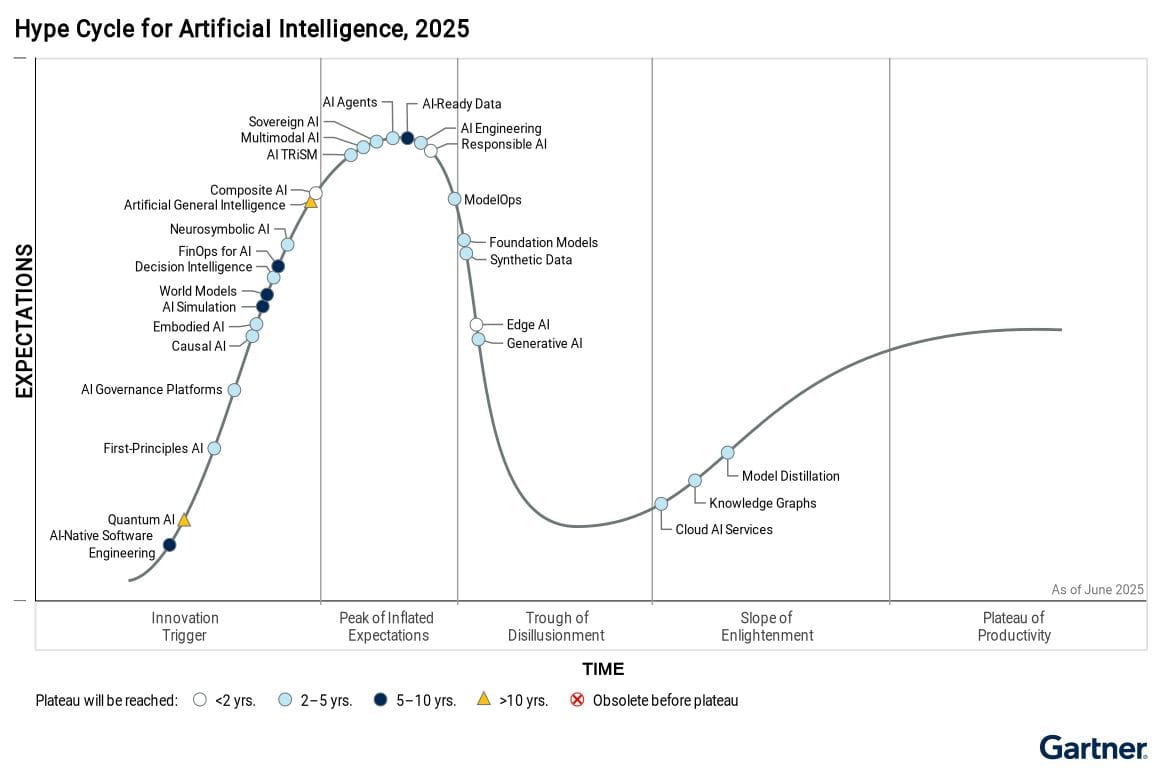

Изкуствен интелект (ИИ) е леко претенциозно название на доста разнообразна палитра от технологии. Част от тях са съвсем нови, но са стъпили на вече достигнала зрялост технологична основа. Други се развиват с колебливо ускорение от години и дори десетилетия. А трети, нищо че може би и за тях сте чули съвсем наскоро, вече излизат от т.нар. пик на завишени очаквания, където развитието им често е стремглаво, и се предполага, че в период от няколко месеца до година-две ще се превърнат в част от обичайното. Или пък няма. Предстои да видим.

Напълно разбираемо е любопитството към ИИ, както и тревогите за бъдещето, в което той ще се намеси. Много въпроси обаче нямат нито лесни, нито очевидни отговори, без значение кой и какво твърди с непоклатима убеденост. Спекулациите и опитите за пророкуване какво ни чака и как ще се промени животът ни, са част от медийния буламач, който съпътства всяка нова и сложна технология. Така беше и с интернет, електронната търговия, облачните технологии, социалните мрежи, блокчейн и криптовалутите.

Голяма част от прогнозите не се сбъднаха. Сега на дневен ред е ИИ.

Понеже интернет и социалните мрежи дадоха възможност (за съжаление – и самочувствие) на всеки да се чувства компетентен да обсъжда всичко, гласовете на онези, които наистина имат какво да кажат, остават нечути. И това далеч не са Сатя Надела (Microsoft), Сундар Пичай (Google), а още по-малко Сам Олтман (OpenAI, които стоят зад разработката на ChatGPT).

Те, разбира се, винаги имат какво да кажат, но нека не забравяме, че като бизнесмени трябва да продават – очаквания, мечти, страхове или каквото е нужно за положителните резултати във финансовите отчети на компаниите, които управляват. Или пък да влияят на нашите мечти, очаквания и страхове, пак заради същите финансови отчети. Това не прави твърденията им безпочвени. Поне не всички. Но измества акцента върху по-съществени въпроси – например кога казват нещо, какво не казват и най-вече защо.

За жалост, дори експерти, които работят в сферата, също невинаги са благонадежден източник на информация. Те са твърде фокусирани върху детайлите и емоционално увлечени от работата си. Някои според мен дори се нуждаят от специализирана помощ. Мнозина са продукт (и жертва) на една силно конкурентна среда, която фаворизира трескавото създаване на технологии без много замисляне върху последиците. Среда, в която техническата надпревара е удобно и всепризнато извинение да не се поема и носи отговорност. А целта – пари, надвиване на конкуренцията, власт – оправдава всички средства.

Трудно е да се оцени ИИ еднозначно, при това без да се залита в крайности като технооптимизъм или параноя.

Всяка технология има своите силни страни и своите недостатъци. Заедно с това, малцина съобразяват оценките си с хуманизма, който днешният пазарно ориентиран технологичен свят има навика напълно да игнорира. С този текст ще насоча вниманието към приглушените гласове – с надеждата повече хуманитаристи и интелектуалци да навлязат в темата.

Независимо от това какво ще е съвместното бъдеще на ИИ и хората, разговорът за това бъдеще е вече закъснял. Защото скоростта, с която ИИ навлиза в живота ни, може да причини такъв световъртеж, че дори при най-позитивното развитие на технологиите те да са твърде сложни за възприемане и осмисляне. Голямото предизвикателство пред човечеството е доколко то ще е способно да се адаптира към тези промени – в икономически, обществен и дори психологически план.

Болезненият въпрос е не дали някои хора ще загубят работата си – това се случва и без ИИ. А каква част ще съумеят да следват промените с нужното темпо. Защото отговорът, че тези, които не успяват, не са подготвени за новите реалности (и както обикновено сами са си виновни), сега няма да ни свърши работа. За да водим обаче адекватен разговор по темата, е нужно поне базово да познаваме технологиите от семейството на ИИ. Ще се опитам да обобщя най-важното от развитието им, без да прекалявам с техническите подробности.

Кратък хронологичен разбор на ИИ

Едва ли е голяма изненада, че модерните днес ChatGPT, Gemini AI, CoPilot и подобни са стъпили на раменете на купчина предхождащи ги технологии – като невронните мрежи, големите масиви от данни, машинното (само)обучение, обработката на естествени езици като част от компютърната лингвистика и дори математическата статистика. Тези технологии не са се появили вчера, някои от тях се развиват от десетилетия.

Една от първите софтуерни програми, които (с известни уговорки) са в състояние да издържат теста на Тюринг, тоест да заблудят някого, че разговаря с човек, е ELIZA – чатбот, създаден още през 60-те години на миналия век, който имитира психотерапевт. ELIZA е програмирана да разпознава ключови думи и шаблони, на които реагира по предварително зададен начин съгласно система от правила. Един от недостатъците на този подход е, че програмата всъщност няма никакво понятие за контекста на разговора, който „води“ (а всъщност симулира). Компетенциите ѝ се изчерпват със системата от правила и сферата, от която са. Няма и механизъм за някакво самообучение или разширяване на тези „компетенции“.

В отговор на недостатъците се появяват технологиите за т.нар. подсилващо обучение (reinforcement learning, или RL), които дават възможност на системата да се адаптира към контекста, в който е поставена, и да се учи от масиви от данни и от предходен опит („проба–грешка“ впрочем е един от основните подходи – както е при хората). Много от текстово базираните компютърни игри прилагат тези технологии от години. Недостатъците на подхода са, че компетенциите отново са ограничени до някаква област (от която са данните, използвани за обучението), ефективността на обучаване е ниска и отнема много време, а нюансите на естествените човешки езици добавят цели нива на сложност.

Така опираме до необходимостта от технологии, които да осигурят някакво ниво на универсалност и обобщаване на знанията. Иначе казано, софтуерът, обучен с едни данни, да е в състояние да прилага „наученото“ в друг контекст, област или ситуация, която не е изрично разписана и подадена предварително. Големите езикови модели (large language model, или LLM) се превърнаха в повратна точка в компютърната обработка на човешки езици. Те ползват многослойни невронни мрежи, за да възприемат и представят големите данни, с които биват обучавани. Всъщност именно те са в основата на днешните чат базирани платформи, които постепенно (и погрешно) приравнихме с ИИ.

Добре е да се има предвид, че езиковите модели всъщност имат едно ключово умение, и то е да предполагат най-вероятната следваща дума в изречението, така че то да стане част от смислово свързан текст. Наричат се още предвиждащи машини. И това не е ирония, а термин. Захранени с голям масив от данни, те боравят с вероятностни разпределения и успяват чудесно да комбинират най-сполучливите (тоест най-вероятните), подредени в правилен словоред думички по такъв начин, че да заговорят (и пишат) като нас. Даже по-добре от нас. На почти всеки език.

В действителност езиковите модели са едни високотехнологични папагали, които повтарят заучени фрази – нищо повече.

Но това все пак е революция в областта на компютърната обработка на човешките езици, която от години беше затънала в опити да описва лексика и граматика със сложни системи от правила.

Внимателно избягвах думата знание и вместо нея ползвах компетенции, защото дотук разполагахме основно с комплект от специализирани умения за съставяне и съпоставяне на текстове. Масивите от данни, с които захранваме езиковите модели обаче, са знание. Нещо повече, това е част от натрупаното общочовешко знание. И тук стигаме до първородния грях – това знание в повечето случаи е събрано и ползвано за обучение на езиковите модели незаконно, без позволение, без компенсации за авторство, без дори признание за авторите му. Хилядолетното знание на човечеството бе откъснато от създателите му и предоставено на машините на тепсия – от търговците на мечти и страхове. Но ще се върнем на това престъпление малко по-нататък.

Именно езиковите модели са това, което направи популярни ChatGPT и подобните нему. GPT всъщност е съкращение от generative pre-trained transformer, което се предполага да преведем като предварително обучен генеративен преобразувател. Именно GPT системите се появиха и се утвърдиха като най-добрите езикови модели (понеже не всички езикови модели са GPT).

Преобразувателите обаче също не са съвършени – това, че са в състояние да сглобят правдоподобен текст и да върнат най-вероятния отговор от голямата си, но все пак ограничена база със знания, съвсем не означава, че това, което твърдят, е истина или е правилно. Точно затова е изключително глупаво да се допитват до тях за здравни или пък романтични съвети, за политиката, бъдещето и т.н. Моделите могат да бъдат изключително некомпетентни в някои области – особено в онези, в които и самите ние, хората, сме боси или пък по някаква причина натрупаното знание не е леснодостъпно. Актуални и очевидни неща, като днешните новини, какво е времето навън или колко е часът, ги затрудняват, защото са обучени с по-стара информация.

Или поне доскоро беше така. Сега те вече разполагат с механизми и инструменти да търсят в интернет и дори да се питат и да си помагат едни на други. Чрез технологии като RAG, допълнителни интерфейси и добавяне на различни инструменти,

ИИ платформите отдавна не са само голи езикови модели.

По сходен начин се появиха и моделите, специализирани в създаването на изображения, глас, музика, видео.

И тук опираме до един вододел, който е много важен за разбирането на контекста на темата. Невронните мрежи, стоящи в основата на езиковите модели, не са нова идея. Техният възход точно сега е резултат от комбинирането им с големите масиви от данни и наличието на изчислителни мощности, каквито доскоро не бяха възможни.

За една група експерти и учени това е доказателство, че технологията не е ефективна, а разхищението на ресурси не води до желаното мащабиране. В другата посока са онези, които вярват, че понеже невронните мрежи се опитват да копират човешкия мозък (доколкото изобщо знаем как функционира той), ако те бъдат захранени с достатъчно данни и изчислителна мощ и продължаваме да ги развиваме, в някакъв момент ще разполагаме с т.нар. общ изкуствен интелект (ОИИ) – artificial general intelligence, или AGI, който ще може да се справя автономно с всяка интелектуална задача, без ние да трябва да му помагаме.

По тази тема всякакви хора напоследък се упражняват да гадаят – между как това никога няма да стане и как т.нар. технологична сингулярност буквално ни дебне зад ъгъла. В интерес на истината, и двата лагера имат своите валидни аргументи.

Днес обаче, колкото и да са добри в това, което правят, моделите преизползват прагматично информацията, без да я разбират в някаква дълбочина. Този проблем се опитват да решат т.нар. разсъждаващи модели (reasoning language model, или RLM), които могат да анализират ситуации, да правят логически изводи и да вземат информирани решения на базата на това, с което са обучени, и на допълнителните данни, до които могат да получат достъп. Подобно на ученик, който не само запаметява факти, но и прилага критично мислене при решаване на реален проблем.

Те са доста нова технология, която, разбира се, също има своите ограничения и проблеми. Невинаги успяват да разглобят правилно сложните задачи на по-прости и решими проблеми. Провалят се при по-заплетени казуси – точно като нас, хората. Загубват се в някои логически взаимовръзки, когато нямат достатъчно контекст да ги подредят по приоритет или пък им липсва достатъчно информация, за да вземат решение. Страдат от предубеждения в зависимост от данните, с които са обучавани...

Познато, нали? Всъщност никак не е случайно, че толкова много си приличаме, дори в недостатъците.

Нека не забравяме, че като продукт на първородния грях те разполагат с огромен комплект от знания и правят дедуктивни заключения на базата на нашите решения и действия от миналото, които сме документирали и предоставили. В този смисъл те доста добре ни познават и копират. Включително в това да имитират страдание, болка, съчувствие и разбиране. Затова, когато прочетете някъде, че някакъв изкуствен интелект страдал или се страхувал да не бъде изключен, моля... намерете си друго четиво.

Една от актуалните новости са т.нар. ИИ агенти. Те представляват софтуер, който, разчитайки на моделите и на допълнителни инструменти и данни, включително постъпващи в реално време, може да извършва напълно автономно някаква специализирана дейност – да управлява машина, да пише софтуер, да шофира, да приема и обработва поръчки в електронен магазин, да помага или даже да замени служител в колцентър или отдел за поддръжка – и да прави това бързо, неуморно, на множество езици и едновременно за много клиенти. Агенти с разсъждаващи модели могат да анализират данни за пациенти, да диагностицират болести и да препоръчват терапии, като в някои случаи успяват даже да са по-прецизни от лекарите.

Важно е обаче да правим разлика между това, че специализиран ИИ e в състояние да анализира и сравнява резултати от ядрено-магнитен резонанс и да бъде дори по-прецизен от лекар при диагностицирането на дадено онкологично заболяване – и това да се допитваме до папагала ChatGPT за медицински съвет, който с огромна вероятност може да е непрецизен и дори погрешен.

Горе-долу тук се намираме днес. И независимо как е прозвучал текстът ми досега, тези технологии са страхотни. Имат огромен потенциал и приложения и би било глупаво да не ги използваме. Първо, те наистина могат да ни помагат за много неща и да ни спестят досадна дейност, усилия и време. Могат дори да спасяват човешки живот. Освен това, искаме или не, те са тук и който не ги познава и използва, рискува да изостане в личното и професионалното си развитие. И не на последно място, ако опасенията, които технологиите пораждат, се оправдаят в бъдеще, тези, които ги познават по-добре, ще имат по-добри шансове – защото, ползвайки силните им страни, интуитивно ще са опознали и слабостите им.

Слабости на ИИ? Разбира се, че има – и те не са малко

Огромен проблем е, че ИИ е гигантски консуматор на електроенергия и изчислителни ресурси. Неотдавна Сам Олтман каза пред Сената, че цената и изобилието на ИИ ще зависят пряко от цената и изобилието на енергия. Иначе казано, без инвестиции в енергийна инфраструктура нуждите на ИИ може да надскочат развитието на електроснабдителните мрежи.

ИИ вече се определя като „космическата надпревара на ХХI век“ и поне засега тя се основава на енергия и ресурси. Това може сериозно да размести баланса на силите в световен мащаб – но пък прекрасно устройва играчи като Сам Олтман, чиято цел е максимално да придърпат темата за ИИ към себе си. Ако Илън Мъск в последно време успя да се превърне в злодея на всички злодеи, изчакайте още малко Сам Олтман.

Икономически сметката все още не излиза. Инвестициите в ИИ са огромни, а възвръщаемостта е ниска. Някои скорошни анализи даже сигнализират, че е достигната фаза на намаляваща възвръщаемост, когато добавянето на ресурси (данни и изчислителна мощ) не увеличава ефективността. Очакванията са огромна част (над 90–95%) от стартъпите за ИИ да фалират бързо и да се получи поредна концентрация около няколко от най-големите технологични играчи.

Скоростта е другият проблем. Като всяка нова технология ИИ се развива много бързо и това не е новина. Различното този път е, че потенциалът му да променя най-различни области от човешкото ежедневие е огромен. При това по-бързо, отколкото са обичайните човешки способности за адаптация. Много по-бързо отколкото процесите, заложени в социално-политическите ни системи от десетилетия преди появата му, могат да реагират. Не е случайно, че наричаме тези характеристики на технологиите разрушителни или подривни. Не непременно с негативна конотация, защото очакваме те да водят до положителни резултати, но такива промени с висока скорост имат всички шансове да увеличат общото усещане за глобален хаос и несигурност, което и бездруго не липсва.

Дали ИИ/ОИИ някога ще бъде в състояние да създава ново знание, да трупа опит и да се самоусъвършенства без човешка намеса, предстои да видим. Това, предполага се, би ускорило още повече всичко. Но дори да не се развие по този начин, някои от тревогите по отношение на днешния ИИ не са неоснователни – за екологията, за разхищаването на енергия, за бъдещите обществено-икономически отношения. За отговорността. Защото кой носи отговорността за дадено решение, действие или бездействие на ИИ като част от една или друга система, не е само юридически или философски въпрос.

Затова отсъствието на хуманитаристите от този сложен разговор е много тревожно.

Разговорът, както и решенията, не бива да остават единствено в кръга и властта на технократите и технооптимистите. Те вече сътвориха достатъчно бели с наивността или с алчността си, с бруталната си самоувереност, пълна липса на критично мислене и неспособност да носят отговорност. Достатъчен пример са социалните мрежи, които уж трябваше да свързват хората, а се превърнаха в терен за културни войни и инструмент за радикализация. И така са на път да счупят демокрациите.

ИИ създава предизвикателства, каквито не познаваме и за които не изглежда да сме готови – нито като индивиди, нито като общества. Правителствата не разбират добре какво става, подценяват евентуалните проблеми и пропиляват безценно време за подготовка. А тривиалните решения няма да сработят. Регулацията не помага особено, защото нерегулираният ИИ (например в Китай) би се развил повече и би надделял над регулирания. В ситуация на глобална технологична надпревара това ще е самоубийствено.

Макар че поне някаква регулация е необходима – високи данъци върху ИИ например биха помогнали да се компенсират някои щети, но само на теория, защото колко ще са политиците с гръбнак да се преборят за това. А и без общо съгласие в глобален мащаб ефектът ще е по-скоро обратен. Колко вероятно е да постигнем такова съгласие в света, който споделяме днес? Освен ако точно ИИ не ни научи най-накрая, че всички на планетата сме в една лодка...

Разбира се, че полза от вторачване в евентуални негативни сценарии няма. Но да не сме подготвени за тях би било безотговорно – защото, ако през предното стъкло изглежда, че сме се засилили с мръсна газ към бетонна стена, решението не е нито да стискаме очи, нито да се надяваме стената да се отмести. Някак трябва да вземем завоя.

П.П. Преди точно 20 години, на 12 юни 2005 г., Стив Джобс произнесе реч пред завършващите „Станфорд“, която и до днес има силно въздействие с възгледа си за пресичането на сферите на хуманизма и технологиите. Дано той не е бил един от последните технологични лидери, за когото това е имало значение.

„Тоест“ се издържа от читателски дарения

Ако харесвате нашата работа и искате да продължим, включете се с месечно дарение.

Подкрепете ни